Es aceptado que el test RT-PCR (reacción en cadena de la polimerasa con transcriptasa inversa) es el mejor método disponible para la detección del virus SARS-CoV-2 [1–4]. Aunque sea considerado como Gold Standard o referencia, el test RT-PCR, como toda prueba diagnóstica, no es perfecto y también arroja resultados incorrectos. Según se ha podido determinar, el mejor desempeño se obtiene durante la primera semana de aparición de los síntomas, con una sensibilidad del orden de 85-90% y una especificidad de 99% o más. Los diagnósticos incorrectos se deben en gran medida a la etapa de la infección en la que se toma el examen, problemas en la muestra biológica o errores de procedimiento del personal técnico [1,5,6].

En este artículo intentaré explicar los aspectos centrales del desempeño de un test diagnóstico: sensibilidad, especificidad y los valores predictivos. También incluyo algunos cálculos y una que otra reflexión sobre la positividad como indicador para evaluar el estado de la pandemia de COVID-19. Para efectos de lo que pretendo exponer me referiré siempre al test RT-PCR, ya que es el principal examen usado para confirmar casos y con él se construyen los indicadores de positividad [7–11].

1. Lo sensible y lo específico del test

La sensibilidad es la probabilidad de que una persona contagiada dé un resultado positivo. Dicho de otra forma, si la sensibilidad del test RT-PCR es de 90% (o 0,9 si lo expresamos estrictamente como probabilidad) quiere decir que, de 100 personas contagiadas, en 90 de ellas el resultado será positivo. Esto implica que, a su vez, 10 de ellas obtendrán un resultado negativo. Estos 10 diagnósticos incorrectos se conocen como falsos negativos.

Por otro lado, la especificidad es la probabilidad de que una persona libre del virus dé un resultado negativo. Para el test RT-PCR, una especificidad de 99% significa que, al tomarlo a 100 personas sanas, sólo para una de ellas dará positivo, diagnóstico fallido conocido como falso positivo.

Según lo anterior, podemos decir que el test es más sensible mientras mejor es su capacidad de diagnosticar correctamente a las personas infectadas, y es más específico cuanto mejor es para diagnosticar correctamente a las personas no infectadas. El problema es que ambas cosas no varían siempre en el mismo sentido, existiendo exámenes muy sensibles y muy específicos al mismo tiempo, muy sensibles y poco específicos, o muy específicos y poco sensibles.

2. ¿Cuánto creerle al test? Valores predictivos y algo sobre la positividad

Para entender qué tan bien funciona un test diagnóstico en la práctica no basta con conocer sus indicadores de calidad "de fábrica", como son la sensibilidad y especificidad. También debemos saber qué tan confiables son sus resultados cuando se aplican en una población o grupo determinado, y para esto usamos los valores predictivos.

El valor predictivo positivo (VPP) es la probabilidad de que una persona cuyo resultado fue positivo esté realmente contagiada. Nuevamente podemos facilitar la explicación pensando que, de 100 personas con resultado positivo, cuántas de ellas están realmente con el virus. Naturalmente, mientras más alto este indicador (más cercano a 1 o a 100%) más confiable es el resultado positivo para indicar o "predecir" (de ahí su nombre) el verdadero estado de la persona.

El valor predictivo negativo (VPP), por su parte, es la probabilidad de que una persona con resultado negativo del examen esté realmente libre del virus. Es decir, de 100 personas que dieron negativo, cuántas de ellas de verdad no están contagiadas.

Para efectos de simplificar el siguiente ejercicio, vamos a suponer que el examen RT-PCR se hace siempre en las mismas condiciones (por ejemplo, durante la primera semana de los síntomas) y que tiene una sensibilidad de 90% y una especificidad de 99%. Quiero aclarar desde ya que los valores que usaré de prevalencia, aunque basados en cierta lógica, son arbitrarios al fin y al cabo.

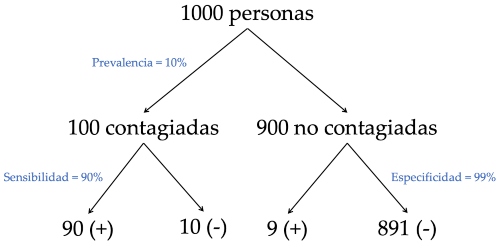

Supongamos que hacemos una campaña de testeo en la comunidad y examinamos a 1000 personas, de las cuales 100 están contagiadas (con esto estamos suponiendo una prevalencia de casos de 10%). De acuerdo a la sensibilidad y especificidad del test, los resultados positivos y negativos se distribuirán como se muestra en el diagrama de la Figura 1.a): 90 positivos y 10 negativos en las personas contagiadas, 9 positivos y 891 negativos en las personas sin el virus.

Si sumamos todos los positivos, éstos son 99 en total, de los cuales 90 corresponden a personas contagiadas. Esto quiere decir que el 91% (90 de 99) de las personas que dan positivo están realmente contagiadas, esto es, 91 contagiadas por cada 100 resultados positivos. Ahora, si hacemos un cálculo similar con los negativos, éstos son en total 901, de los cuales 891 están efectivamente libres del virus. Esto representa un 99%, es decir, 99 realmente libres del virus de cada 100 resultados negativos. Es claro que en este escenario sería mucho más confiable un resultado negativo del test que uno positivo, ya que el primero tiene un 99% de probabilidad de ser cierto (VPN) y el segundo sólo un 91% (VPP). Notar que la positividad en este grupo es del 10% (99 resultados positivos en las 1000 personas examinadas), coincidente con la prevalencia de casos.

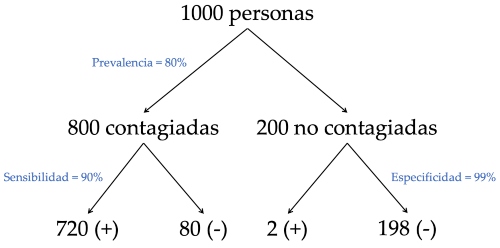

Pensemos ahora en un grupo de 1000 pacientes que consultan por síntomas asociados a COVID-19. Supongamos que 800 de estos pacientes están contagiados (prevalencia de 80%), y que al examinarlos con RT-PCR los resultados positivos y negativos se distribuyen como se muestra en la Figura 1.b). Haciendo cálculos similares obtenemos un VPP de 99,7% (720 contagiados de 722 positivos) y un VPN de 71% (198 libres del virus de 278 negativos). En este caso la credibilidad del resultado negativo caería drásticamente, indicando que casi un 30% de los resultados negativos son pacientes que sí están contagiados, es decir, falsos negativos. Además, la positividad en este grupo es del 72% (722 resultados positivos de 1000 exámenes), más baja que la prevalencia real.

Si ahora juntamos ambos grupos en uno solo de 2000 personas, tenemos que la prevalencia de casos en este total es de 45% (900 personas contagiadas de las 2000). Si sumamos los resultados positivos y negativos y hacemos los cálculos respectivos, tenemos un VPP de 99% (de los 821 positivos, 810 son personas contagiadas) y un VPN de 92% (1089 libres del virus de 1179 resultados negativos). La positividad es de 41% (821 resultados positivos de 2000 exámenes).

Figura 1.a) Resultados de testear a mil personas con 10% de prevalencia de la infección, considerando una sensibilidad de 90% y una especificidad de 99%.

Figura 1.b) Resultados de testear a mil personas con 80% de prevalencia de la infección, considerando una sensibilidad de 90% y una especificidad de 99%.

De lo anterior podemos hacer algunas observaciones importantes:

i) Los valores predictivos cambian según la prevalencia en la población

El desempeño y la capacidad predictiva de los resultados positivos y negativos varían según el porcentaje de personas infectadas en el grupo testeado. En particular, para una prevalencia relativamente baja el VPN es superior al VPP, es decir, los resultados negativos son más confiables que los positivos. En esta situación de baja prevalencia la falla en los diagnósticos tiene como consecuencia que aumentan los falsos positivos, es decir, habrá más personas no infectadas diagnosticadas como contagiadas, las que deberán realizar cuarentenas y tomar las medidas establecidas para los casos de COVID-19.

En contraste, cuando la prevalencia de casos es alta, como podría darse en medio de la pandemia en las personas que consultan por síntomas, los resultados positivos son mucho más probables de ser ciertos que los negativos. La consecuencia de esto para un virus altamente contagioso puede ser mucho más peligrosa que en la primera situación, dado que aumenta el número de falsos negativos, es decir, personas diagnosticadas como no contagiadas que quedarían sin ninguna medida y podrían seguir haciendo sus actividades habituales y contagiando a otras.

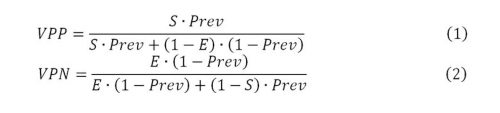

Del Teorema de Bayes tenemos que los valores predictivos positivo y negativo están dados por

donde S: sensibilidad del test; E: especificidad del test; Prev: prevalencia de casos en el grupo de personas testeadas.

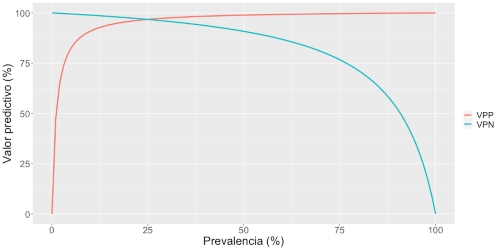

En la Figura 2 se muestra la relación entre la prevalencia y los valores predictivos, considerando siempre una sensibilidad de 90% y una especificidad de 99%. Por ejemplo, para una prevalencia de 50% el VPN desciende hasta 90%, lo que significa que 10 de cada 100 resultados negativos corresponden a personas infectadas.

Figura 2: Relación entre la prevalencia del virus y los valores predictivos positivo (VPP) y negativo (VPN) del test, considerando una sensibilidad de 90% y una especificidad de 99%.

ii) Positividad y prevalencia

Cuando la prevalencia es baja la positividad del test se aproxima bien a dicha prevalencia, mientras que cuando es alta la positividad subestima la prevalencia real. Esto es coherente con el resultado anterior y debiera llevarnos a ser cautos con la interpretación que se hace de la positividad.

También podemos tener una idea de cómo es esta relación, ya que la positividad equivale a la probabilidad de un resultado positivo, dada por

P(+)=S∙Prev+(1-E)∙(1-Prev)=[S-(1-E)]∙Prev+(1-E) (3)

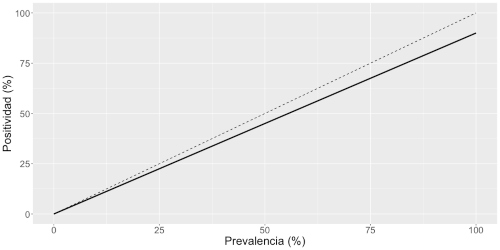

En la Figura 3 vemos dicha relación que, como indica la última expresión de la ecuación 3, es una recta cuya pendiente es la diferencia entre la sensibilidad (S) y la proporción de falsos positivos (1-E). Se muestra además con una línea discontinua el caso en que la prevalencia es igual a la positividad, que sería el caso ideal si el test no fallara nunca. Vemos que la recta continua indica que la positividad es menor a la prevalencia, con una diferencia que va en aumento a medida que la prevalencia es mayor. Esto sugiere que el indicador de positividad estaría ocultando o distorsionando lo que está ocurriendo en la población estudiada, y esa distorsión aumenta proporcionalmente al aumento del propio indicador.

Figura 3: Figura 3: Relación entre la prevalencia y la positividad del test, considerando una sensibilidad de 90% y una especificidad de 99%. La línea discontinua indica la recta de identidad, que corresponde al caso ideal en que la prevalencia coincide con la positividad (un test que no falla nunca).

iii) ¿Positividad total o separada?

Cuando testeamos dos grupos con prevalencias muy distintas, éstas se combinan y pueden llevar a resultados que no representan ni a una ni a la otra. En el ejemplo mostrado ocurre esto cuando consideramos el total de 2000 pacientes, donde la prevalencia total es 45% y se obtiene una posibilidad total de 41%. Dichos grupos son iguales en tamaño y por lo tanto el total se divide en un 50% con prevalencia baja y 50% con prevalencia alta. Sin embargo, si estos porcentajes varían, la positividad puede estar influenciada por el grupo con mayor presencia y distar aún más de la prevalencia real.

En Julio de 2020 se implementó la Estrategia Nacional de Testeo, Trazabilidad y Aislamiento (TTA), y una de sus acciones es la Búsqueda Activa de Casos (BAC), la que tiene como objetivo la detección de casos de COVID-19 que el sistema de salud no ha pesquisado por consulta espontánea [12–15]. Un indicador reportado desde entonces es el porcentaje de tests RT-PCR por BAC respecto al total de tests RT-PCR realizados, tanto por comuna como por región [8,9]. Este porcentaje ha ido aumentando en el tiempo, llegando a alcanzar el 100% en algunas comunas.

Si por búsqueda activa se toma un porcentaje importante del total de exámenes, y la positividad en este grupo es muy pequeña, entonces la positividad total disminuye. Un aspecto importante para reflexionar entonces es si la positividad total es un indicador adecuado, dado que podemos estar mezclando dos poblaciones distintas en términos de su prevalencia de casos.

3. Comentarios finales

He intentado mostrar y explicar los indicadores de desempeño de los exámenes diagnósticos, esto es, sensibilidad, especificidad y los valores predictivos, usando ejemplos sencillos y refiriéndome al test RT-PCR usado para detectar el virus SARS-CoV-2.

Una observación importante es que el resultado del test diagnóstico usado será más o menos confiable no sólo según sus características propias de calidad (sensibilidad y especificidad), sino también de acuerdo a la población o grupo de personas a la que se aplique. En términos generales, cuando la prevalencia de casos es baja debemos cuestionarnos la interpretación de los resultados positivos. Sin embargo, cuando la prevalencia es alta (por ejemplo, en pacientes que consultan por síntomas de COVID-19) aumentan los falsos negativos, con el consecuente peligro del subreporte de un virus tan contagioso como éste, al dejar sin medidas a personas infectadas que pueden propagar más la enfermedad.

Por otro lado, el indicador de positividad usado para la toma de decisiones de control epidemiológico (junto a otros indicadores) tiene ventajas incluso por sobre el número de casos, ya que éstos dependen del número de exámenes practicados. Si los exámenes se aplicaran a una muestra aleatoria de la población y se corrigiera por la sensibilidad y especificidad del test, la positividad sería una buena estimación de la prevalencia de casos. Sin embargo, esto no ocurre ya que es impracticable aplicar exámenes a una muestra aleatoria. Entonces, cabe preguntarse si la positividad debería ser tratada con mayor cautela para saber a qué grupos de la población representa.

La búsqueda activa de casos (BAC) es una muy buena y necesaria estrategia, pero combinar la positividad obtenida a través de la BAC con la positividad de las personas que consultan puede estar llevando a un indicador que no está entregando la información que se necesita, ya que se pueden estar combinando grupos con prevalencias muy distintas. Si fuese así, quizás sea mejor reportar dos positividades separadas: una para las personas que consultan en los centros de salud y otra para la comunidad obtenida a través de la búsqueda activa de casos, siempre resguardando el seguimiento y aislamiento de los casos positivos y sus contactos.

Agradecimiento

Quiero agradecer a mis queridas colegas Sandra Flores del Programa de Bioestadística, por la revisión que hizo a la apurada y desordenada primera versión de este manuscrito, y Tania Alfaro del Programa de Epidemiología, por la revisión al documento ya más avanzado. La mirada crítica, observaciones y comentarios de ambas fueron esenciales para corregir y "podar" el documento, además de evitar aberraciones en el lenguaje y ayudar a poner los énfasis donde era necesario.

Referencias